MHC Talker

让Metahuman“活”起来的数字人AI工具

虚幻引擎实时驱动

MHC Talker

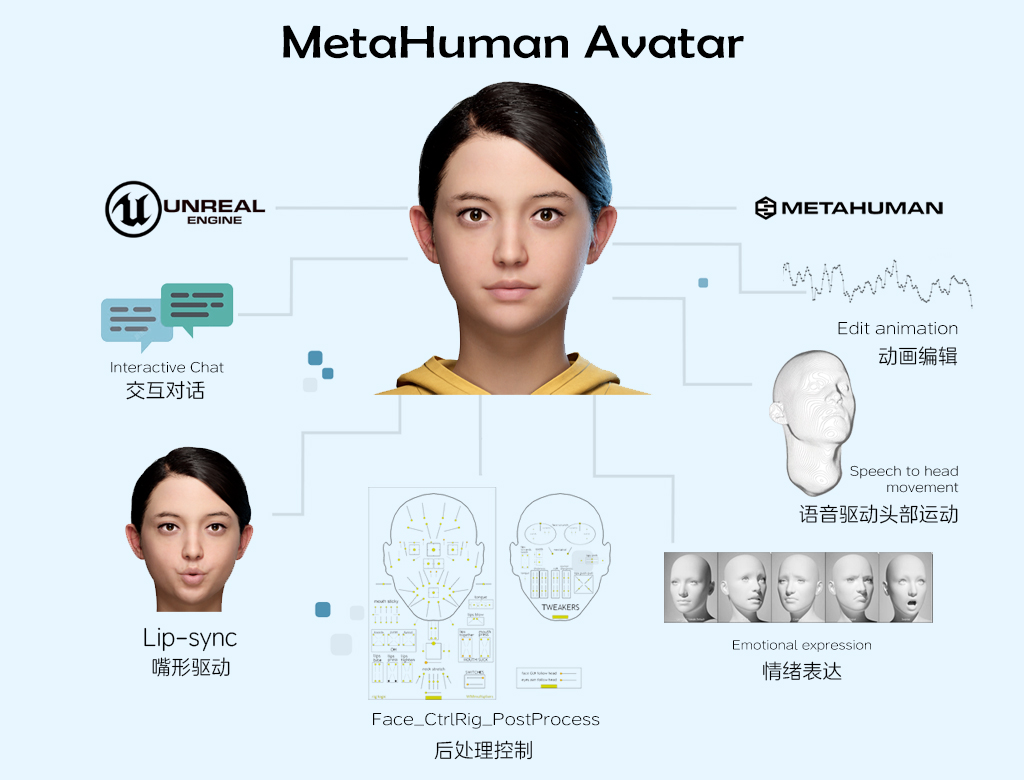

在Unreal Engine中调用AnimaCore API,实时驱动Metahuman角色高质量对话。一键配置智能对话角色,功能包括:文字或语音对话,实时口型驱动,后处理微调表情,语音重读自然头部运动,肢体动作对话逻辑驱动,动画数据录制等。

此外,角色资产的DNA和BS修型对角色的动画表现尤为重要,确保角色的DNA和BS修型符合MetaHuman官方标准规范;

一键式Metahuman配置

面向个人或团队美术人员,无需复杂编程,通过可视化界面绑定Metahuman角色模型、语音库、AI服务接口,快速完成角色“智能化”配置。

文字/语音双通道输入

支持用户通过文本输入或实时语音与Metahuman角色互动,角色可自动识别语义并生成符合语境的语音回复,实现真正意义上的双向对话。

实时口型推理同步

基于深度学习算法,精准解析语音内容,实时驱动口型与发音高度匹配,告别机械式口型动画,呈现真实自然的对话表现。全语种支持。

语音重读与头部微动作联动

通过语音重音识别技术,自动触发角色头部自然摆动、点头、侧倾等微动作,模拟人类对话时的下意识反应,大幅提升交互真实感。

后处理表情微调控制

提供精细化的表情控制面板,支持对AI生成的表情进行细节调整(如嘴角弧度、眼神聚焦、皱眉强度等),实现从“基础情绪”到“细腻情感”的精准刻画。

对话逻辑驱动的肢体动作库

角色可根据对话内容自动触发匹配的肢体动作(如手势、耸肩、摊手等),并支持逻辑规则自定义。例如:提问时头部前倾、强调时挥手、疑惑时耸肩,动作与语义深度绑定。

MHC Talker演示

实时交互对话

3D数字人实时对话

功能包括:

- AI实时语音唇形同步

- 角色人物背景设定

- 肢体表达逻辑行为驱动

- 语音情绪驱动表情

- 后处理微调表情

- 超多语音类型可选

- ... ...

出色的多语言泛化能力

F.A.Q.

常见问题

MHC Talker支持哪些角色绑定标准?

目前MetaHuman标准方案是通用型绑定最佳选择,现阶段仅支持MetaHuman标准的绑定方案,后续将推出更多方案支持。

MHC Talker支持自定义大语言模型或自定义语音吗?

支持,MHC Talker可接收文本和语音,将文字或语音发送插件接口即可,具体操作可查看相关文档。

MHC Talker是否支持Unity?

目前MHC Talker只支持Unreal Engine,未来将考虑更新Unity版本。

支持Unreal Engine哪些版本?

支持Unreal Engine5.3、5.4、5.5版本,持续更新。

支持Unreal Engine哪些系统?

目前支持Windows、Linux两个系统。

支持Unreal Engine打包的平台有哪些?

目前支持打包Windows、Linux和Android。